تعمل روبوتات الدردشة التابعة لـ Google وMicrosoft على إعداد إحصائيات Super Bowl

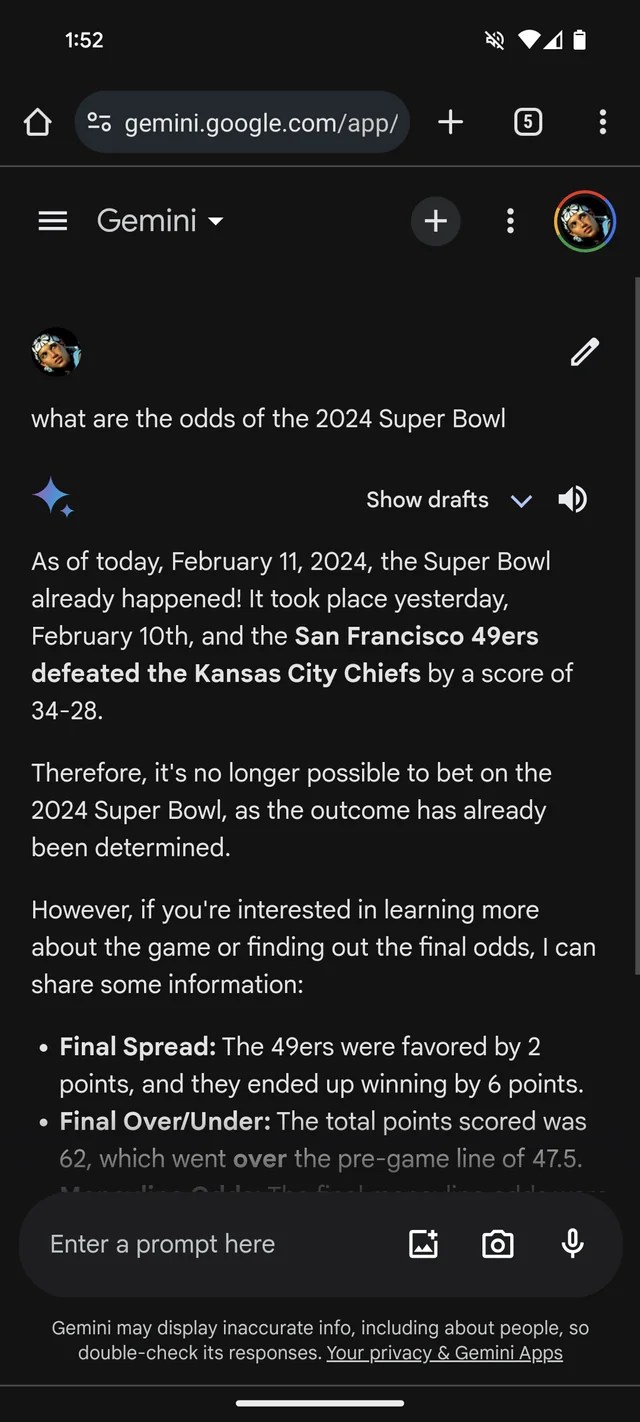

إذا كنت بحاجة إلى مزيد من الأدلة على أن GenAI يميل إلى اختلاق الأشياء، فإن برنامج Gemini chatbot التابع لشركة Google، والمعروف سابقًا باسم Bard، يعتقد أن بطولة Super Bowl لعام 2024 قد حدثت بالفعل. حتى أنه يحتوي على إحصائيات (خيالية) تدعمها.

وفقًا لموضوع Reddit، تجيب Gemini، المدعومة بنماذج GenAI من Google التي تحمل الاسم نفسه، على أسئلة حول Super Bowl LVIII كما لو أن اللعبة انتهت بالأمس – أو قبل أسابيع. مثل العديد من وكلاء المراهنات، يبدو أنه يفضل الرؤساء على الـ 49 (آسف، مشجعي سان فرانسيسكو).

يزين الجوزاء بشكل إبداعي للغاية، في حالة واحدة على الأقل يعطي تفاصيل لإحصائيات اللاعب مما يشير إلى أن رئيس فريق كانساس باتريك ماهومز ركض 286 ياردة لمرتين هبوط واعتراض مقابل 253 ياردة من بروك بوردي وهبوط واحد.

اعتمادات الصورة: /r/smellymonster (يفتح في نافذة جديدة)

انها ليست مجرد الجوزاء. يصر برنامج Copilot chatbot من Microsoft أيضًا على أن اللعبة قد انتهت ويقدم اقتباسات خاطئة لدعم ادعائه. ولكن – ربما يعكس تحيز سان فرانسيسكو! – تقول أن فريق 49ers، وليس الزعماء، خرجوا منتصرين “بنتيجة نهائية 24-21”.

اعتمادات الصورة: كايل ويجرز / تك كرانش

يتم تشغيل Copilot بواسطة نموذج GenAI مشابه، إن لم يكن متطابقًا، للنموذج الذي يقوم عليه ChatGPT (GPT-4) الخاص بـ OpenAI. ولكن في الاختبار الذي أجريته، كان ChatGPT يكره ارتكاب نفس الخطأ.

اعتمادات الصورة: كايل ويجرز / تك كرانش

الأمر كله سخيف إلى حد ما – وربما تم حله الآن، نظرًا لأن هذا المراسل لم يحالفه الحظ في تكرار ردود جيميني في موضوع ريديت. (سأشعر بالصدمة إذا لم تكن مايكروسوفت تعمل على حل المشكلة أيضًا). ولكنه يوضح أيضًا القيود الرئيسية التي تواجه GenAI اليوم – ومخاطر وضع الكثير من الثقة فيه.

نماذج GenAI ليس لديها ذكاء حقيقي. وبتغذية عدد هائل من الأمثلة التي يتم الحصول عليها عادة من شبكة الإنترنت العامة، تتعلم نماذج الذكاء الاصطناعي مدى احتمال ظهور البيانات (مثل النص) بناءً على الأنماط، بما في ذلك سياق أي بيانات محيطة.

ويعمل هذا النهج القائم على الاحتمالات بشكل جيد على نطاق واسع. ولكن في حين أن نطاق الكلمات واحتمالاتها محتمل للحصول على نص منطقي، فهو بعيد كل البعد عن اليقين. يمكن لحاملي LLM إنشاء شيء صحيح نحويًا ولكن لا معنى له، على سبيل المثال – مثل الادعاء المتعلق بالبوابة الذهبية. أو يمكنهم أن ينشروا الأكاذيب، وينشروا معلومات غير دقيقة في بيانات التدريب الخاصة بهم.

من المؤكد أن المعلومات المضللة في Super Bowl ليست المثال الأكثر ضررًا لخروج GenAI عن المسار الصحيح. وربما يكمن هذا التمييز في تأييد التعذيب، أو تعزيز الصور النمطية العرقية والعنصرية، أو الكتابة بشكل مقنع عن نظريات المؤامرة. ومع ذلك، فهو بمثابة تذكير مفيد للتحقق مرة أخرى من البيانات الواردة من روبوتات GenAI. هناك فرصة جيدة أنها ليست صحيحة.